한국어 원어민과 일본어-한국어 및 중국어-한국어 이중언어 사용자 간 음운규칙 적용 여부에 따른 단어재인 시 ERP 성분 비교

Phonological Activation in Korean Word Recognition between Korean Native Speakers and Japanese-Korean and Chinese-Korean Bilingual Speakers: Evidence from Event-Related Potentials

Article information

Abstract

배경 및 목적

본 연구는 음운규칙 적용 유무에 따라 단어재인과정에서 한국어 원어민과 일본어-한국어 이중언어 사용자, 중국어-한국어 이중언어 사용자 간 차이를 사건관련전위(event-related potential, ERP)를 통해 살펴보고자 하였다.

방법

한국어 원어민, 일본어-한국어 이중언어 사용자, 중국어-한국어 이중언어 사용자를 대상으로 시각자극 제시 이후 들리는 청각자극과 비교하여 음운규칙이 올바르게 적용되었는지에 대해 판단하도록 하는 음운판단과제를 사용하여 진행하였다.

결과

행동분석 결과, 집단 내 음운규칙 적용 여부에 따른 정반응률과 반응시간에서 모두 유의미한 차이가 나타났다. ERP 분석 결과, 시각자극 제시 후 N250 구간에서 집단 간 유의미한 차이가 나타났다. 음운규칙 적용 여부에 따라서도 유의미한 차이가 나타났다. 청각자극 제시 후 N400 구간에서 음운규칙 적용 유무에 따라서는 유의한 차이를 보였다.

논의 및 결론

제2외국어로 한국어를 사용하는 이중언어 사용자는 한국어 원어민보다 단어재인 초기에 자소-음소 전환이 활발하게 이루어지지 않으나 단어재인 능력에 차이를 보이지 않음을 알 수 있었다. 따라서 이중언어 사용자 일지라도, 한국어에 노출되는 시간을 늘리고, 음운규칙이 적용되는 단어를 많이 접한다면 한국어 원어민과 동일한 자소-음소 처리를 할 수 있다는 가능성을 제시한다.

Trans Abstract

Objectives

The purpose of this study is to explore the differences of real-time processing in word recognition according to the application of Korean-specific phonological rules among Korean native speakers, Japanese-Korean bilinguals, and Chinese-Korean bilinguals through the Event-Related Potentials (ERP) analysis.

Methods

Subjects were 15 native Korean speakers and 27 bilingual speakers: 13 Japanese-Korean and 14 Chinese-Korean speakers who learning Korean as a second language. They were asked to judge whether the pronunciation of the visual stimulus word was identical to the corresponding auditory stimulus word.

Results

All three groups showed a significant difference in both the judgment accuracy (%) and reaction time (ms) when the phonological rules were applied. In other words, the judgment accuracy was higher and reaction time was faster under the condition of applying the phonological rules than the condition without the phonological rules. ERP analysis after the visual stimulus presentation show that a significant difference among three groups and between two conditions was in amplitudes of N250. After the auditory stimulus, a significant difference between two conditions was found in amplitudes of N400.

Conclusion

The results indicated that by increasing exposure time to Korean and learning more words with the phonological rules, they are likely to make identical grapheme-phoneme processing to that of native speakers.

한국어는 자소-음소 대응규칙(grapheme-phoneme correspondence rules)에 따라 비교적 일관성을 갖는다. 하지만 두 음절 이상의 단어를 읽을 때에는 음절과 음절 사이에서 음운이 변화하는 현상이 일어난다. 음운이 변화하는 현상에 규칙성이 있다. 이를 음운규칙이라고 부르며, 자연스럽게 한국어를 읽기 위해서는 음운규칙을 이해하고 적용할 수 있는 능력이 필요하다. 한국어 원어민의 경우 교과과정에 음운규칙이 포함되어 있어 초등학교 고학년에 이르면 성인과 비슷한 수준의 음운규칙 능력을 보인다(Lim & Kim, 2008).

한국어를 제2언어로 습득하는 이중언어 사용자(bilingual)에게 한국어 음운규칙은 한국어 습득을 어렵게 하는 요소 중 하나이다. 언어권에 따른 음운규칙 적용의 오류를 비교한 Heo (2012) 연구에 따르면, 음운규칙이 많지 않은 중국어를 모국어로 하는 한국어 이중언어 사용자는 비음화와 유음화에서 가장 많은 오류를 보인다. 한국어와 문법적으로 유사성이 많은 일본어를 모국어로 하는 한국어 이중언어 사용자의 경우에는 한국어를 상대적으로 쉽게 배우지만 발음 학습에는 어려움을 보인다. 또한 타 언어권 이중언어 사용자와 달리 격음화에서 높은 오류를 보인다. 선행연구들은(Kim & Baek, 2015; Heo, 2012; Rhee, Kim, & Chang, 2007) 이러한 오류의 원인으로 모국어와의 관계성 또는 음운론적 난이도 등을 제시한다. 하지만 선행연구 모두가 행동분석을 하는 수준에서 진행되었기에, 한국어 이중언어 사용자의 모국어에 따라 신경학적 측면에서 언어처리에 어떠한 차이가 있는가를 확인할 수 없다는 한계점이있다. 따라서 본 연구는 한국어 원어민뿐만 아니라 한국어를 학습하는 중국인과 일본인들의 한국어 음운규칙의 신경학적 처리과정을 비교분석하기 위해 뇌파의 변화를 실시간으로 살펴볼 수 있는 사건관련전위(event-related potentials, ERP) 연구를 실시하였다.

사건관련전위(ERP)는 인지적 처리가 요구되는 상황에서 자극이 제시된 후 특정 시간대에 발생하는 뇌파(Electroencephalogram, EEG)를 평균화하여 얻는 값으로 뇌의 활동전위를 실시간으로 보여준다. 따라서 시간에 따른 대뇌의 인지정보 처리과정을 완벽하게 측정할 수 있다. 사건관련전위 중 N250 성분은 자극 제시 후 250 ms 전후에 음의 방향(negative)으로 정점이 보이는 사건관련전위로서, 시각단어 재인 시 어휘처리 이전의 초기 음운처리 단계 즉, 자소-음소 대응처리를 반영한다고 알려져 있다. 선행연구들(Liu, Perfetti, & Hart, 2003; Grainger & Holcomb, 2009; Kwon, Nam, & Lee, 2015)에 따르면 N250은 점화자극과 목표자극의 표기 또는 발음이 다를 경우 활성화되어 나타난다. 예를 들어, 목표자극 ‘같이’와 관련성이 없는 점화자극 ‘나무’를 제시했을 경우가, 음운 또는 표기적으로 목표자극과 관련있는 점화자극인 ‘가치’를 제시했을 경우 보다 크게 나타난다는 것이다. P200 성분은 자극 제시 이후 200 ms대에 이르러 양의 방향(positive)으로 정점이 보이는 사건관련 뇌 전위 요인으로서, 의미처리 이전에 나타나는 음운처리 관련 성분이며 표기나 음운이 일치할 때 가장 크게 나타난다(Liu et al., 2003). N400은 자극제시 이후 400 ms대에 이르러 음의 방향(negative)으로 정점을 보이는 사건관련 뇌 전위 요인으로서, N400의 크기는 의미적 활성화와 밀접한 관련이 있는 것으로 알려져 있다(Kwon & Lee, 2016). 외국에서는 단어를 재인하는 동안의 음운 및 어휘처리에 대한 ERP 연구가 진행되어왔다. Grainger, Kiyonaga와 Holcomb (2006)은 표기자극과 음운 자극의 시간적 처리 과정을 살펴보았다. 이들은 표기정보가 유사한 조건(예: ‘brain-BRAIN’, 통제자극 ‘bosin-BRAIN’)과 음운정보가 유사한 조건(예: ‘brane-BRAIN’, 통제자극 ‘brant-BRAIN’)을 비교하여 연구를 진행하였다. 그 결과, 각 조건 모두 통제자극에서 큰 N250을 보였다. 즉, N250은 음운이나 표기가 일치하는 조건에서 작게 활성화되며, 음운이나 표기가 일치하지 않은 조건에서 크게 활성화된 것이다. 두 조건에서 N250이 활성화된 결과는 시각 단어재인을 하는 동안 하위어휘(sublexical) 처리를 반영하는 가설을 지지하며, 시간처리과정에서 표기자극이 음운자극보다 먼저 선행되는 것을 확인할 수 있었다. 스페인어와 영어를 사용하는 이중언어 사용자를 대상으로 언어전환 시 사건관련전위를 살펴본 연구(Fengyang, Peiyao, Taomei, & Judith, 2017)에 의하면, L1 단어가 L2 단어로 올바르게 해석되어 있는지 판단하는 과제에서도 목표자극(예, perro, 스페인어로 ‘개’를 뜻함)과 형태가 일치하는 자극(예, dot, 영어로 ‘개’를 뜻하는 ‘dog’와 형태가 일치)일 경우에 P200이 크게 활성화 되었고 의미가 일치하는 경우(예, dog)에서는 N400이 작게 활성화가 되었다. Hoshino, Midgley, Holcomb 그리고 Grainger (2010)는 일본어와 영어를 사용하는 이중언어 사용자를 대상으로 L1과 L2 단어 자극을 ‘L1-L1’, ‘L1-L2’, ‘L2-L1’, ‘L2-L2’ 조건으로 제시하여 의미범주 판단과제를 진행했다. 그 결과, 모국어 조건(L1-L1), 제2언어 조건(L2-L2)에서 N250과 N400의 활성화를 밝혔다.

최근 한국에서는 시각 단어재인 시 음운정보의 영향을 살펴본 연구(Kwon et al., 2015) 이외에, 의미와 무의미 단어의 음운규칙 적용 여부에 따른 단어재인 과제를 실시하는 동안 뇌파를 분석한 연구(Choi, 2017), L1-L2의 전환과정을 살펴본 연구(Kim, 2010) 등이 실시되었다. Kwon 등(2015)의 연구에서는 어휘판단과제를 사용하여 점화자극에 따른 단어재인의 과정을 살펴보았다. 그 결과, 목표자극(예, 녹말)과 음운 및 표기와 관련이 없는 통제조건(예, 적감)을 점화자극으로 제시했을 때 N250의 큰 활성화가 관찰되었다. Choi (2017)의 연구에서는 의미와 무의미 단어를 사용하여 음운규칙 적용 여부에 따른 단어재인 과정을 살펴보았다. 그 결과, 무의미 단어에서 보다 의미 단어에서 P200, N250, N400의 활성화가 더 일어났으며, 음운규칙이 적용되는 의미 단어 자극에서 N250이 작게 활성화되었음을 보고하였다. 또한 Kim (2010)의 연구에서는 문장의 의미적절성을 판단하는 과제를 사용하여 실험을 진행하였다. 그 결과, 모국어 질의-응답 조건(L1-L1)에서 의미가 불일치할 경우 N400이 활성화되었다. 외국어 답변 조건(L1-L2)에서는 N400이 나타났으나 의미 일치 유무에 따라 차이는 나타나지 않았다.

본 연구는 한국어 원어민과 외국어로 한국어를 습득한 일본어 및 중국어 이중언어 사용자를 대상으로 음운규칙 처리과정을 행동분석과 뇌파 분석을 통해 살펴봄으로써, 일본인과 중국인이 한국어 자소-음소 전환할 때 요구되는 음운규칙의 신경학적 처리과정을 한국어 원어민과 비교하는데 목적을 두었다. 위에서 언급된 국내에서 진행된 선행연구들은 단어재인 과정을 시각적 측면에서만 살펴보았거나, 비교집단을 설정하지 않았다. 따라서 본 연구는 한국어 이중언어 사용자와 한국어 원어민을 대상으로 음운규칙을 적용하여 읽어야 하는 단어를 시각자극으로 제시한 뒤에, 청각자극을 제시하여, 피험자가 음운판단을 하는 방식으로 실험 설계함으로써, 집단 간 행동분석 및 ERP 결과를 비교하고자 하였다. 이를 위해 본 연구는 (1) 한국어 원어민과 비교하여 일본어-한국어 및 중국어-한국어 이중언어 사용자들이 실제로 한국어 음운규칙을 적용하는데 얼마나 어려움을 보이는지를 정반응률과 반응시간을 통해 행동분석을 하였고, (2) 음운규칙 적용 유무에 따른 ERP 특성의 집단 간 비교를 N250, P200 및 N400을 중심으로 실시하였다.

연구방법

연구대상

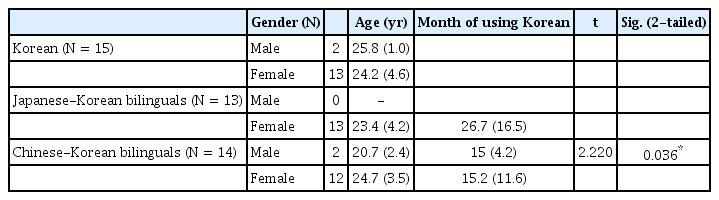

본 연구는 한국어 원어민 15명(남자 2명, 여자 13명, 평균 연령 25±2.8), 일본어-한국어 이중언어 사용자 13명(남자 0명, 여자 13명, 평균 연령 23.4±4.2), 중국어-한국어 이중언어 사용자 14명(남자 2명, 여자 12명, 평균 연령 22.4±3)으로 총 42명이 참여하였다. 한국어 원어민 화자의 경우 한국어를 모국어로 하는 서울 및 경기도에 거주하는 대학생과 직장인들로 선정하였다. 일본어-한국어 및 중국어-한국어 사용자는 한국에 거주하면서 어학당 또는 대학에 소속되어 한국어를 습득했거나 습득하고 있는 이중언어 사용자로 선정하였다. 이중언어 사용자는 E-PRIME 형태의 선별검사를 진행했다. 본 실험 전 기초 음운규칙에 대한 지식을 평가한 것으로 음운규칙이 제대로 형성되어 있지 않으면 과제 진행이 어렵다고 판단되었기 때문이다. 따라서, 선별검사에서 70% 미만의 정반응률을 보일 경우 실험에서 제외하였다. 이중언어 사용자 간 한국어 사용 기간에서 유의한 차이가 있는지 알아보기 위해 독립표본 t-검정(independent sample t-test)을 실시하였다. 그 결과, 일본어-한국어 이중언어 사용자의 한국어 사용기간의 평균은 26.7 (SD=16.5)개월로 중국어-한국어 사용자의 한국어 사용기간의 평균 14.9 (SD= 10.7)개월에 비해 유의하게 긴 것으로 나타났다(t=2.220, p<.05).

실험 대상자는 모두 오른손잡이로 시력 혹은 교정 시력 및 청력이 정상이고 언어 및 인지발달에 문제가 없었으며 신경학적 손상 및 정신적 병력이 없는 자들로 교육연수가 12년 이상으로 고등교육을 마친 자들이었다. 본 연구에 참여한 대상자 정보 및 이중언어 사용자 집단의 한국어 사용기간의 차이에 대한 독립표본 t-검정 결과는 Table 1에 제시하였다.

실험 과제

음운규칙 선정

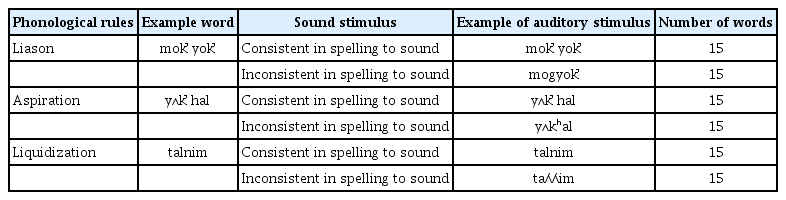

Heo (2012) 연구에 따르면 이중언어 사용자들의 발음 오류는 중국어-한국어 이중언어 사용자의 경우, 연음화에서 가장 적은 오류를 보이며 비음화와 유음화에 가장 많은 오류를 보인다. 일본어-한국어 이중언어 사용자의 경우, 다른 언어권 이중언어 사용자와 달리 격음화에서 매우 높은 오류율을 보인다. 이러한 연구결과에 따라 중국어-한국어 이중언어 사용자와 일본어-한국어 이중언어 사용자 모두에게 난이도가 낮은 ‘연음화’, 중국어-한국어 이중언어 사용자에게 중간 난이도이며 일본어-한국어 이중언어 사용자에게 높은 난이도를 보이는 ‘격음화’, 중국어-한국어 이중언어 사용자에게 높은 난이도이나 일본어-한국어 이중언어 사용자에게 중간 난이도인 ‘유음화’로 제한하여 살펴보았다.

음운판단과제

실험과제는 6개의 예제 문항과 90개의 실험문항으로 모두 2음절 단어로 구성하였다. 피험자는 음운규칙을 적용하여 단어를 읽어 판단해야 했다. 피험자에게 들려준 청각자극은 두 가지 유형으로 1) 음운규칙을 적용하지 않고 자소와 음소를 일치시켜 읽은 오류 형태의 단어 45개, 2) 음운규칙인 연음화, 격음화, 유음화를 적용하여 읽은 올바른 형태의 단어 45개였다.

과제에 사용된 단어는 한국어 학습용 어휘 선정 결과보고서(Cho, 2003)의 단어목록과 초등학교 교과서에 등장하는 단어 중 음운규칙이 일어나는 단어를 선정하였다. 실험조건 및 자극 예시는 Table 2에 제시하였다. 과제에 사용된 단어목록은 Appendix 1에 제시하였다.

청각자극 녹음

실험에 사용된 모든 청각자극은 쉴드룸에서 디지털 녹음기(Cenix, MVR-W650 Digital Recorder)를 사용하여 아나운서 출신 여성의 음성으로 녹음하였다. 자극들은 디지털 녹음기에 의해 24비트, 96 kHz 디지털 신호로 변환되어 저장되었다. 청각자극에 사용된 단어는 평균 길이가 941 ms (범위 781-1,130 ms)였다.

연구 절차

과제 진행 절차

매 피험자마다 E-Prime 내에서 무작위 배열(random)하여 제시하였으며 실험 전 예제문항을 제시하여 피험자에게 음운판단과제에 대해 설명하였다. 예제문항은 음운규칙별 2개씩 총 6개의 문항을 무작위로 제시하였다. 예제문항에서는 피험자의 반응에 대한 정오반응이 제공되었다.

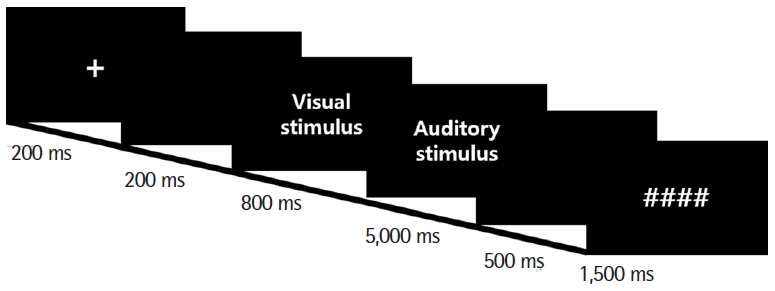

과제 진행 과정은 우선 ‘+’ 표시가 200 ms 동안 화면 가운데 나타나 피험자의 시선을 고정시켰다. 그 후, 200 ms 동안 빈 화면을 보여주었다. 그 다음, 시각자극이 800 ms 동안 모니터 중앙에 제시되었다. 시각자극이 사라지면 청각자극과 함께 빈 화면을 최대 5,000 ms 동안 제시하였다. 청각자극이 제시된 뒤에 ‘단어를 올바르게 읽어 자연스럽다’고 생각하면 키보드의 오른쪽 파란 버튼을, ‘단어를 올바르게 읽지 않아 부자연스러웠다’라고 생각하면 왼쪽 빨간 버튼을 정확하고 빠르게 누르도록 지시하였다. 피험자가 반응을 하면 500 ms의 빈 화면을 제시하였다. 그 후, 눈깜빡임을 할 수 있는 1,500 ms의 시간을 제시하여 다음 문장을 준비할 수 있도록 하였다.

전체 90문항의 실험시간은 약 15분 정도 소요되었고 45문항마다 약 1분간 휴식하였다. 과제가 진행되는 동안 피험자에게 단어를 소리 내어 읽지 않도록 지시하였다. 음운판단과제의 자극제시 순서는 Figure 1에 제시하였다.

ERP 실험

쉴드룸(soundproof and electrically shield room)에서 Brain Pro-ducts사의 BrainAmp와 actiCAP을 사용하여 EEG를 기록하였다. 피험자의 두피에 은/염화은(Ag/AgCI)으로 제작된 전극을 국제 표준방식인 10-20 system (Jasper, 1958)에 따라 FP1, FP2, F7, F3, F4, F8, FC5, FC1, FC2, FC6, T7, C3, CZ, C4, T8, TP9, CP5, CP1, CP2, CP6, TP10, P7, P3, PZ, P4, P8, O1, O2, VEOG의 총 29개를 부착하였다. 뇌파 신호는 500 Hz로 샘플링되었고, 각 전극의 저항은 10 kΩ 이하로 유지하였다. 분석에 포함된 전극은 Anterior left (FP1, F3, FC5, FC1, F7), Anterior right (FP2, F4, FC2, FC6, F8), Posterior-left (CP5, CP1, P7, P3, O1), Posterior-right (CP2, CP6, P4, P8, O2)이다(Choi & Sim, 2019).

자료 분석

음운판단과제의 정반응률은 피험자가 정반응한 문항을 전체 문항수로 나누어 백분율(%)로 산출하였다.

반응시간은 1/1,000초(ms) 단위로 측정하여 청각자극이 제시된 뒤 피험자가 판단하여 버튼을 누르기까지의 시간을 측정하였다. 반응시간의 경우 선행연구(Choi & Sim, 2019)와 동일하게 정반응을 보인 문항들에 대해서만 분석하였으며 정반응률과 반응시간 모두 E-prime을 통해 측정되었다.

피험자들이 음운판단과제에서 정반응 보인 EEG 데이터를 The MathWorks사의 MATLAB R2013b에서 EEGLAB v.12.02.0.5b와 Brain products사의 Brain Vision Analyzer 2.0.3을 이용하여 분석하였다. 피험자가 정반응한 문항들을 250 Hz에 맞추어 다시 샘플링 하였다(Luck, 2014, p227). 시각자극 제시 전 200 ms부터 800 ms, 청각자극 제시 전 200 ms부터 800 ms까지 총 2,000 ms 동안의 구간(epoch)을 잘랐다. 인지작용에 대한 뇌파를 추출하기 위해 0.1-30 Hz 범위에서 필터링하였고, 눈 깜박임 등으로 인한 기타 잡음은 제거하였다(Luck, 2014). 이러한 과정을 거친 뒤 남은 시행들을 조건별로 추출하여 평균을 낸 뒤 ERP 파형을 구하였다.

본 연구의 첫 번째 질문인 한국어 원어민과 이중언어 사용자 간 음운규칙 적용 여부(자소-음소 일치, 자소-음소 불일치)에 따른 단어재인 시 정반응(%) 및 반응시간(ms)의 차이가 유의한지 알아보기 위하여 이원혼합분산분석(two-way mixed ANOVA)을 실시하였다. 두 번째 연구 문제인 한국어 원어민과 이중언어 사용자 간 음운규칙 적용 여부(자소-음소 일치, 자소-음소 불일치)에 따른 단어재인 시 ERP 평균진폭(mean amplitude, μV)에 유의한 차이가 있는지 알아보기 위해 사원혼합분산분석(four-way mixed ANOVA)을 실시하였다. 통계 분석은 SPSS ver. 25 (SPSS Inc., Chicago, IL, USA)를 사용하였다.

연구결과

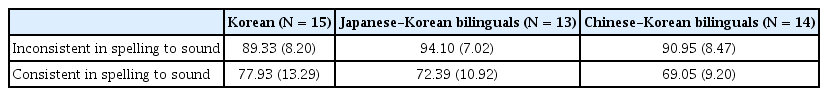

정반응률

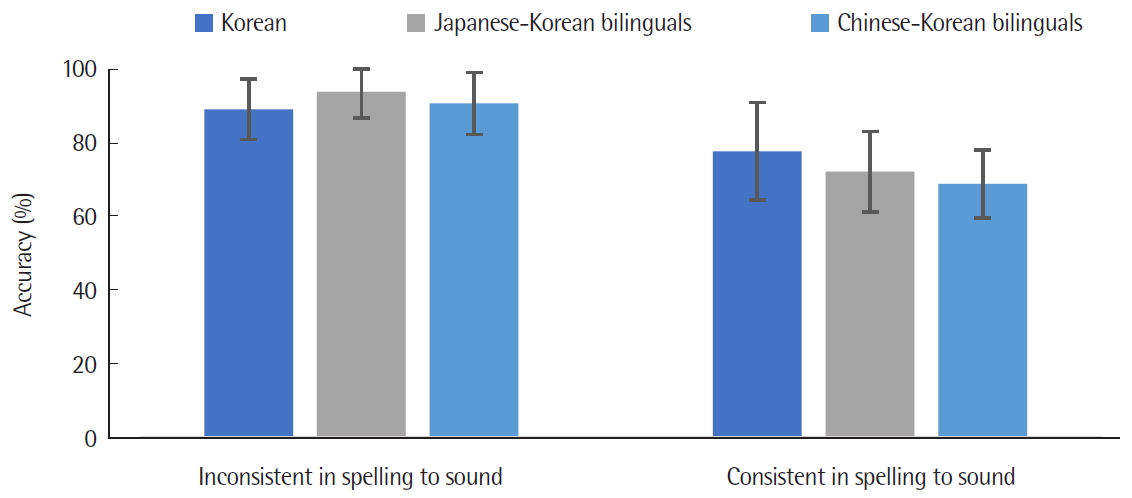

음운규칙 적용 여부에 따른 집단 간 정반응률의 차이를 알아보기 위해 집단, 음운규칙 적용 여부를 독립변인, 음운판단과제의 정반응률(%)을 종속변인으로 하는 이원혼합분산분석(two-way mixed ANOVA)을 실시하였다. 음운규칙 적용 여부에 따른 집단별 정반응률(%)의 평균 및 표준편차는 Table 3에 제시하였으며, Figure 2에는 평균과 표준오차를 제시하였다.

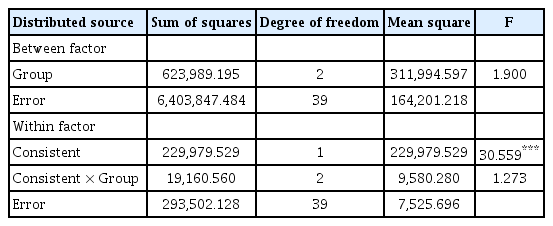

집단 간 음운판단과제의 정반응률(%)은 통계적으로 유의하게 차이가 없는 것으로 나타났다. 반면에 음운규칙 적용 여부에 대한 주효과가 유의하게 나타났다(F(1, 39)=66.593, p<.001). 즉, 음운규칙을 적용한 조건에서의 정반응률(91.46%)이 음운규칙을 적용하지 않은 조건에서 정반응률(73.12%)에 비해 유의하게 높았다. 음운규칙 적용 여부와 집단 간의 이차상호작용은 통계적으로 유의하지 않았다. 이원혼합분산분석(two-way mixed ANOVA) 결과는 Table 4에 제시하였다.

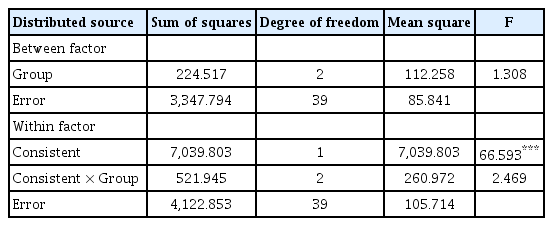

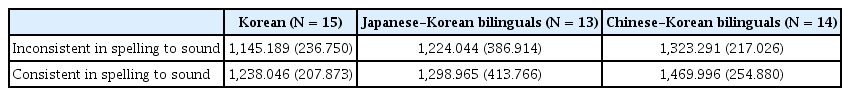

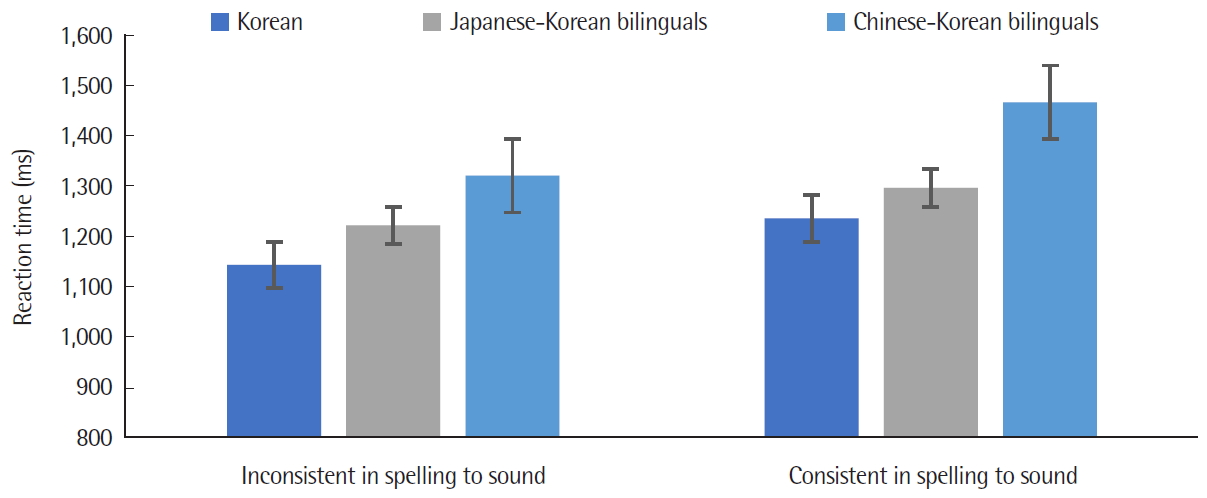

반응시간

음운규칙 적용 여부에 따른 집단 간 반응시간의 차이를 알아보기 위해 집단, 음운규칙 적용 여부를 독립변인, 음운판단과제의 반응시간(ms)을 종속변인으로 하는 이원혼합분산분석(two-way mixed ANOVA)을 실시하였다. 음운규칙 적용 여부에 따른 집단 별 반응시간의 평균 및 표준편차는 Table 5에 제시하였으며, Figure 3에는 평균과 표준오차를 제시하였다.

집단 간 음운판단과제의 반응시간은 통계적으로 유의하지 않은 것으로 나타났다. 반면에 음운규칙 적용 여부에 대한 주효과가 통계적으로 유의하였다(F(1, 39)=30.559, p<.001). 즉, 음운규칙을 적용한 조건에서의 반응시간(1,230.84 ms)이 음운규칙을 적용하지 않은 조건에서의 반응시간(1,335.67 ms)에 비해 유의미하게 더 짧았다. 음운규칙 적용 여부와 집단의 이차상호작용은 통계적으로 유의하지 않았다. 이원혼합분산분석(two-way mixed ANOVA) 결과는 Table 6에 제시하였다.

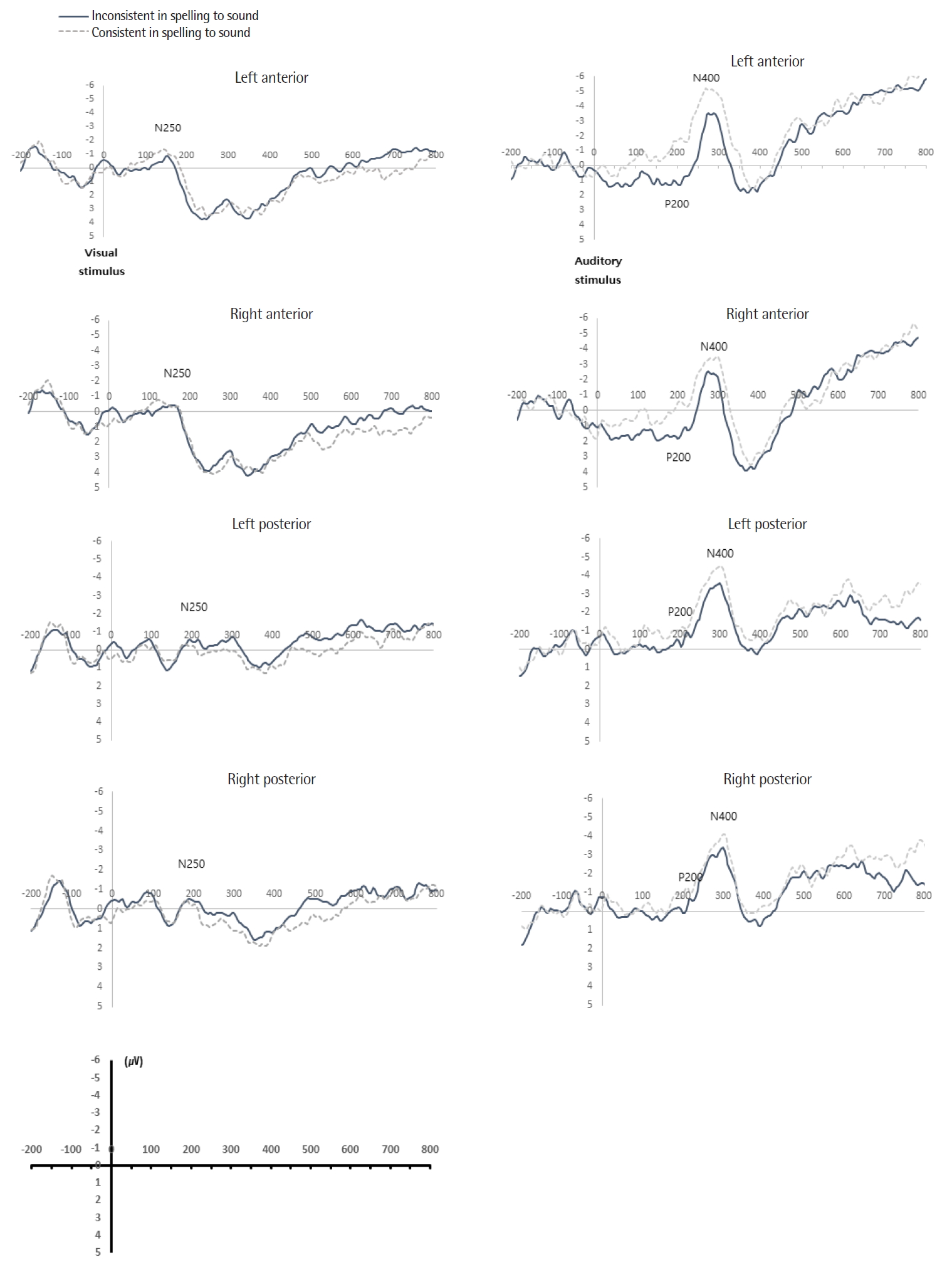

평균진폭(mean amplitude) 크기 분석

전극 위치별 음운규칙 적용 여부에 따른 ERP 분석의 평균 파형(grand average wave forms) 결과는 다음 Figures 4-6에 제시하였다. 다음 그림은 점화자극 제시시점을 기준으로 뇌전위 그래프를 제시한 Kwon과 Lee (2016) 연구와 동일한 방식으로 제시하였다. 집단 모두 시각자극 제시 이후 N250은 약 180 ms에서 나타났으며, 청각자극 제시 이후 P200 진폭은 약 200 ms에서 나타나며, N400 진폭의 시작점은 약 300 ms에서 나타났다.

Grand average event-related potential (ERP) waveforms of two conditions at four regions for Korean: word with incorrect pronunciation with unapplied phonological rules (consistent in spelling to sound), word with correct pronunciation with applied phonological rules (inconsistent in spelling to sound).

Grand average event-related potential (ERP) waveforms of two conditions at four regions for Japanese-Korean bilinguals: word with incorrect pronunciation with unapplied phonological rules (consistent in spelling to sound), word with correct pronunciation with applied phonological rules (inconsistent in spelling to sound).

Grand average event-related potential (ERP) waveforms of two conditions at four regions for Chinese-Korean bilinguals: word with incorrect pronunciation with unapplied phonological rules (consistent in spelling to sound), word with correct pronunciation with applied phonological rules (inconsistent in spelling to sound).

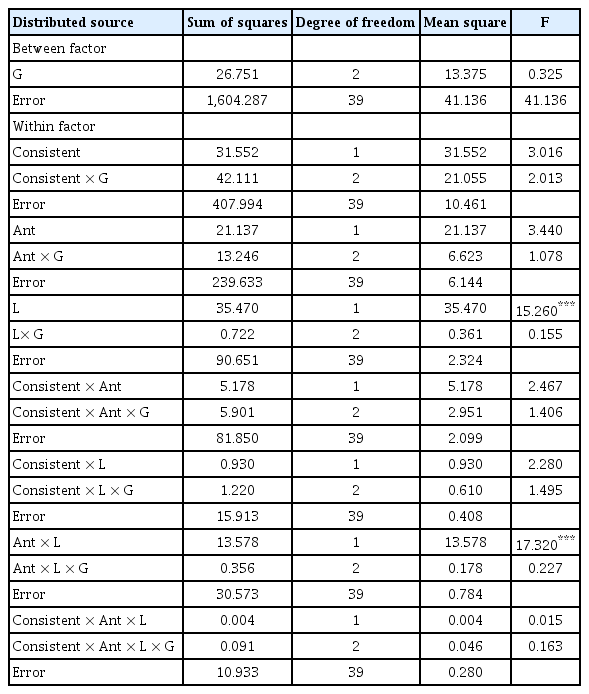

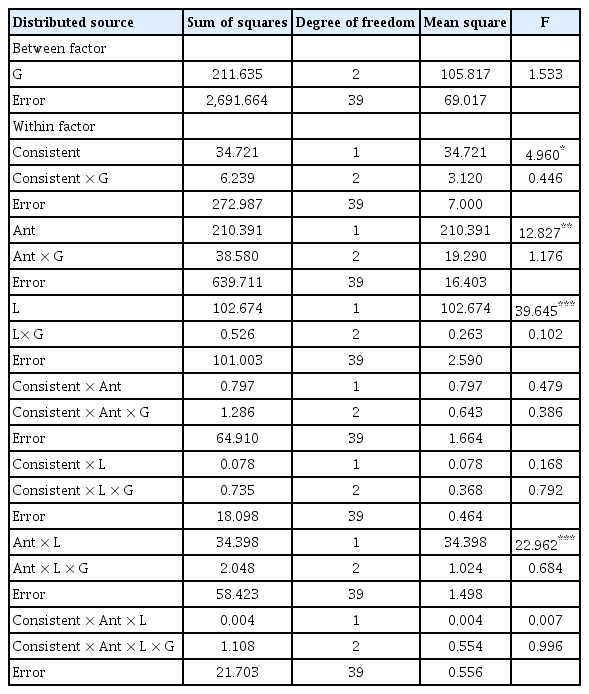

자극 제시 후 각 구간별 평균 진폭의 차이를 알아보기 위하여 집단, 음운규칙의 적용 여부(적용, 비적용), 좌우측영역(좌측, 우측 영역), 전두-후두영역(전두, 후두영역)을 독립변인, 음운판단과제의 평균진폭을 종속변인으로 하는 사원혼합분산분석(four-way mixed ANOVA)을 실시하였다. 그 결과 Tables 7-9에 제시하였으며 주효과 및 상호작용은 분석 구간별로 나누어 기술하는 부분에서 보다 상세하게 통계적 효과가 의미하는 바를 기술하였다.

ERP 결과: N250 (200-350 ms)

음운규칙 적용 유무에 따른 음운판단과제의 집단 간 시각자극 제시 후 200-350 ms 구간의 평균 진폭에서 집단에 대한 주효과가 통계적으로 유의하였다(F(2, 39)=7.283, p<.01). 따라서 Bonferroni 사후검정을 통하여 주효과에 대한 대응별 비교를 실시하였다. 그 결과, 한국어 원어민과 일본어-한국어 이중언어 사용자, 한국어 원어민과 중국어-한국어 이중언어 사용자는 유의한 차이를 보였으나 중국어-한국어 이중언어 사용자와 일본어-한국어 이중언어 사용자 간에는 유의한 차이를 보이지 않았다. 즉, 시각자극 제시 후 200-350 ms 구간에서 집단 간 평균진폭에 차이를 보였으며 한국어 원어민(1.999 μV)이 일본어-한국어 이중언어 사용자의 평균진폭(5.169 μV)과 중국어-한국어 이중언어 사용자의 평균진폭(5.538 μV)에 비해 음의 방향으로 크게 나타났다.

음운규칙 적용 유무에 대한 주효과가 통계적으로 유의하였다(F(1, 39)=7.584, p<.01). 즉, 시각자극 제시 후 200-350 ms 구간에서의 음운규칙이 적용되었을 때 평균진폭(3.743 μV)이 음운규칙이 적용되지 않았을 때의 평균진폭(4.577 μV)보다 음의 방향으로 크게 나타났다.

좌우측영역에 대한 주효과도 통계적으로 유의하였다(F(1, 39)= 131.501, p<.001). 즉, 시각자극 제시 후 200-350 ms 구간에서 좌측 영역의 평균 진폭(3.921 μV)이 우측영역의 평균진폭(4.399 μV)보다 음의 방향으로 유의하게 큰 것으로 나타났다. 좌우측영역 및 집단 간 이차상호작용이 통계적으로 유의하였다(F(2, 39)=6.568, p<.01). 사후검정을 실시한 결과, 한국어 원어민과 이중언어 사용자 간 유의한 차이를 보였지만 이중언어 사용자 간에는 유의한 차이가 나타나지 않았다.

전두-후두영역에 대한 주효과도 통계적으로 유의하였다(F(1, 39)= 11.963, p<.01). 즉, 후두영역에서의 평균진폭(1.999 μV)이 전두영역에서의 평균진폭(6.321 μV)에 비해 음의 방향으로 유의하게 컸다. 전두-후두영역 및 집단 간 이차상호작용이 통계적으로 유의하였다(F(2, 39)=3.26, p<.05). 사후검정 결과, 한국어 원어민과 일본어-한국어 이중언어 사용자, 한국어 원어민과 중국어-한국어 이중언어 사용자 간의 유의한 차이가 나타났다.

좌우측영역 및 전두-후두영역 간 이차상호작용이 통계적으로 유의하였다(F(1, 39)=9.006, p<.01). 즉, 좌측영역에서 전두-후두영역 진폭 차이가 우측 영역에서의 전두-후두영역 진폭 차이에 비해 큰 것으로 나타났다. 분산분석 결과는 Table 7에 제시하였다.

ERP 결과: P200 (150-300 ms)

음운규칙 적용 유무에 따른 음운판단과제의 집단 간 청각자극 제시 후 150-300 ms 구간의 평균 진폭에서 집단에 대한 주효과는 통계적으로 유의한 차이를 보이지 않았다. 음운규칙 적용 유무에 대한 주효과도 통계적으로 유의한 차이를 보이지 않았다.

좌우측영역에 대한 주효과가 통계적으로 유의하였다(F(1, 39)=15.260, p<.001). 즉, 청각자극 제시 후 150-300 ms 구간에서 우측 영역의 평균 진폭(-0.593 μV)이 좌측영역의 평균 진폭(-1.239 μV)보다 유의하게 큰 것으로 나타났다. 좌우측영역 및 전두-후두영역 간 이차상호작용이 통계적으로 유의미하였다(F(1, 39)=17.320, p<.001). 즉, 우측영역에서 전두-후두영역의 진폭 차이가 좌측영역에서의 전두-후두영역의 진폭 차이에 비해 큰 것으로 나타났다. 분산분석 결과는 Table 8에 제시하였다.

ERP 결과: N400 (300-500 ms)

음운규칙 적용 유무에 따른 음운판단과제의 집단 간 청각자극 제시 후 300-500 ms 구간의 평균진폭에서 집단에 대한 주효과는 통계적으로 유의한 차이를 보이지 않았다.

좌우측영역 및 전두-후두영역에서의 음운규칙 적용 여부에 따른 음운판단과제의 집단 간 청각자극 제시 후 300-500 ms 구간의 평균진폭에서 음운규칙 적용 유무에 대한 주효과가 통계적으로 유의하였다(F(1, 39)=4.960, p<.05). 즉, 음운규칙을 적용했을 때의 평균진폭(-0.111 μV)이 음운규칙을 적용하지 않았을 때의 평균진폭(0.750 μV)에 비해 음의 방향으로 유의하게 크게 나타났다.

전두-후두영역에 대한 주효과도 통계적으로 유의하였다(F(1, 39)= 12.827, p<.01). 즉, 후두영역의 평균진폭(-1.243 μV)이 전두영역의 평균진폭(0.382 μV)에 비해 음의 방향으로 유의하게 큰 것으로 나타났다. 좌우측영역에 대한 주효과도 통계적으로 유의하였다(F(1, 39)= 39.645, p<.001). 즉, 좌측영역의 평균진폭(-.0986 μV)이 우측영역의 평균진폭(0.125 μV)에 비해 음의 방향으로 유의하게 큰 것으로 나타났다.

좌우측영역 및 전두-후두영역 간 이차상호작용이 통계적으로 유의미하였다(F(1, 39)=22.962, p<.001). 즉, 우측영역에서 전후-후두 영역의 진폭 차이가 좌측영역에서의 전두-후두영역의 진폭 차이에 비해 큰 것으로 나타났다. 분산분석 결과는 Table 9에 제시하였다.

논의 및 결론

본 연구의 목적은 한국어 원어민과 일본어-한국어 이중언어 사용자, 중국어-한국어 이중언어 사용자 간의 음운규칙 적용 여부에 따라 집단 간 음운판단과제의 정반응률 및 반응속도, ERP 성분의 평균 진폭(mean amplitude) 크기의 차이를 알아보는 것이다.

집단 간 음운판단과제의 정반응률과 반응시간에 있어 차이를 보이지만 통계적으로 유의하지 않았다. 한국어 원어민의 경우에는 한국어를 모국어로 습득하기 때문에 말소리를 듣고 말하기부터 배우기 시작한다. 읽기를 배우는 과정에서도 자연스럽게 일상생활에 노출되어 습득한다. 반면에, 이중언어 사용자의 경우에는 읽기와 말하기를 거의 동시에 배우게 되며 음운규칙을 학습하고 의식하여 적용한다. 이러한 사실을 미루어보면, 한국어 원어민과 이중언어 사용자는 음운규칙을 습득한 과정은 다르지만, 음운규칙에 대한 음운지식이 집단 모두 형성되어 있기에 정반응률과 반응시간에 집단 간 유의한 차이를 보이지 않았다고 볼 수 있다.

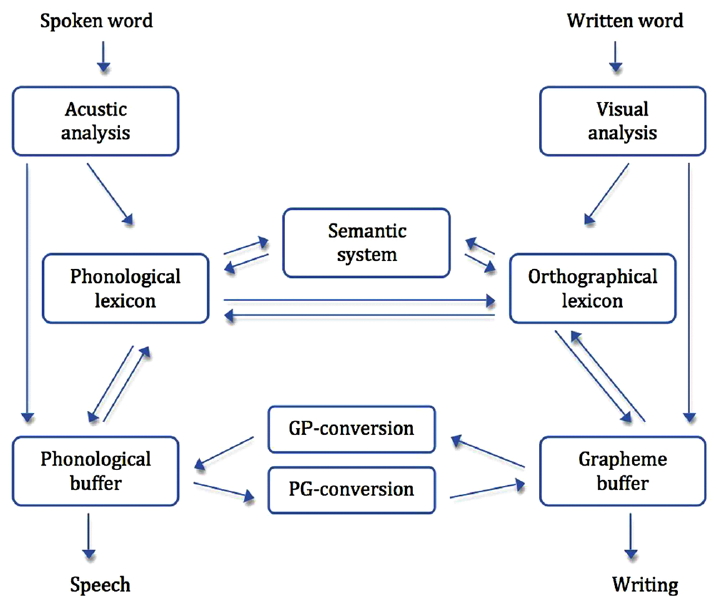

음운규칙 적용 유무에 따라 집단 간 정반응률과 반응시간 모두 유의한 차이를 보였다. 한국어 원어민, 이중언어 사용자 집단 모두 음운규칙을 적용한 경우(예, 시각자극 ‘목욕’, 청각자극 ‘[모굑]’)의 정반응률이 음운규칙을 적용하지 않은 경우(예, 시각자극 ‘목욕’, 청각자극 ‘[목욕]’)의 정반응률 보다 높았다. 또한 반응시간도 음운규칙을 적용한 경우가 음운규칙을 적용하지 않은 경우보다 유의하게 빨랐다. Figure 7에서 제시한 Döhla와 Heim (2016)의 읽기와 쓰기의 이중경로 모델에 따르면, 시각자극이 제시되었을 때에는 시각적 분석(visual analysis)–자소 완충기(grapheme buffer)–자소 음소 변환(grapheme phoneme conversion, GPC)–음운완충기(phonological buffer)를 거친다. 그 다음 제시되는 청각자극을 재인할 때에는 청각적 분석(acoustic analysis)-음운완충기(phonological buffer)의 경로를 거친다. 즉, 시각자극을 제시하였을 때와 청각자극을 제시하였을 때의 처리과정은 동일하지 않기 때문에, 피험자는 각각의 과정을 통해 처리된 결과를 비교하여 정오판단을 해야 한다. 따라서 본 연구에서 피험자는 시각자극(예, 목욕)을 통해 처리한 음운정보(예, [모굑])와 청각자극을 통해 처리한 음운정보(예, 목욕)를 대조하여 판단해야 하기 때문에 긴 시간이 필요했다고 볼 수 있다.

Dual route model (Döhla and Heim, 2016).

ERP 성분에 대한 시간대별 결과를 살펴보면, 시각자극 제시 후 200-350 ms 구간에서 나타난 N250 성분은 집단 간 평균진폭에서 차이를 보였다. N250은 하위-어휘 처리 수준의 자소-음소 대응처리를 반영한다(Grainger & Holcomb, 2009). 선행연구(Hoshino et al., 2010)와 동일하게 점화자극과 목표자극이 모두 모국어인 한국어 원어민은 N250 성분이 크게 활성화되었으나, 한국어를 제2외국어로 사용하는 이중언어 사용자는 N250 성분이 작게 나타났다. 이는 음운을 처리하는 과정에서 이중언어 사용자는 한국어를 모국어로 습득한 경우보다 음운규칙 적용이 활발하게 이루어지지 않아 N250 성분이 작게 나타났다고 해석할 수 있다. 또한 이중언어 사용자에게 제시된 단어가 무의미 단어라고 보았을 때, 시각자극 제시 후 의미 단어에 비해 무의미 단어에서 N250 성분의 활성화를 보고한 Choi와 Sim (2019) 연구와도 동일하다. N250 성분은 음운규칙 적용 여부에 따라서도 평균 진폭에 차이를 보였다. 점화자극이 목표자극과 관련 없는 경우 N250 성분이 크게 활성화된다는 선행연구(Kwon et al., 2015; Grainger & Holcomb, 2006)와 동일한 결과로, 음운규칙을 적용하여 자소와 음소가 일치하지 않게 제시한 음운불일치 조건이 음운규칙을 적용하지 않고 표기 그대로 자소와 음소를 일치시켜 제시한 조건보다 크게 나타났다. 자소와 음소를 일치하지 않게 제시한 음운불일치 조건에서 N250 성분의 활성화는 한국어가 자소-음소 대응이 규칙적임에도 불구하고 자소-음소 처리 과정이 존재한다고 해석된다. N250 성분은 집단 간 좌우측영역, 집단 간 전두-후두영역의 활성화 차이를 보였다. 좌측 하전두이랑(left inferior frontal gyrus)은 읽기에서 자소-음소 대응 처리와 밀접한 관련성이 있는 것으로 알려져 있다(Burton, 2001; Joubert et al., 2004; Kwon & Lee, 2016). 시각자극 제시 이후 하전두이랑에서 자소-음소 대응 처리가 이루어져 활성화에 차이를 보인 것으로 해석된다.

청각자극 제시 후 150-300 ms 구간에서 나타나는 P200 성분은 음운규칙 적용 여부에 따라 차이를 보이지 않았다. P200은 의미처리 이전에 나타나는 음운처리 관련 성분으로 알려져 있다(Liu et al., 2003; Kong et al., 2010). 이 결과는 시각자극만 사용하여 P200 성분을 살펴본 선행연구(Kwon, Lee, & Nam, 2011)와는 달리, 시각자극을 제시하였을 때 초기 자소-음소 처리가 이루어졌기 때문에 다음에 제시되는 청각자극에서는 성분이 관찰되지 않았다고 볼 수 있다.

의미처리 시 활성화를 보이는 N400(청각자극 제시 후 300-500 ms)은 음운규칙 적용 유무에 따른 차이를 보였다. 음운규칙을 적용한 경우 더 큰 진폭을 보인 결과는 의미가 처리되었다고 해석할 수 있다(Kwon & Lee, 2016). Hoshino 등(2010)에 의하면 점화자극과 목표자극을 의미적으로 분류하는 과제를 사용하여 L1과 L2의 처리과정을 보았을 때, L2에 비해 L1을 처리하는 과정에서 N400이 크게 나타난다. 이러한 결과와 동일하게 한국어 원어민이 이중언어 사용자보다 더 큰 N400을 보일 것이라고 판단하였다. 그러나 본 연구에서는 집단 간 N400 성분에 차이를 보이지 않았다. 이러한 결과는 Kim (2010) 연구에서 한국어-영어 이중언어 사용자가 L2인 영어를 처리할 때 N400 효과를 보이지 않은 결과와 일치한다. 선행연구에서는 모국어 자극에서만 N400이 활성화되어 L2를 사용하여 대답하는 것이 영어 모국어 화자의 민감도에 미치지 못함을 시사했다. 또한 모국어에서는 학습한 언어를 전환하지 않고 동일한 언어 내에서 의미적 적절성 여부를 신속히 판단하고 결정할 수 있지만, L2 전환 시에는 모국어의 간섭으로 인해 N400 성분이 정점을 보이지 않았다고 해석하였다. 따라서 본 연구에서 집단 간 의미처리 성분인 N400의 차이를 보이지 않은 이유는 이중언어 사용자 집단이 한국어 원어민에 비해 의미를 처리하는데 민감도가 낮으며 모국어의 간섭으로 인해 보인 차이라고 볼 수 있다.

집단 사이 정반응률과 반응시간에 있어 유의한 차이를 보이지 않은 결과는 한국어 원어민과 이중언어 사용자 집단의 음운지식 습득 과정이 다르더라도 형성되어 있는 단어재인 능력에 차이를 보이지 않음을 알 수 있었다. ERP로 살펴본 단어재인 처리 과정에서도 N250과 N400 성분에 차이를 볼 수 있었다. 이러한 결과는 한국어 원어민과 이중언어 사용자 집단 모두 초기에 자소-음소 전환이 필수적으로 이루어진다고 볼 수 있다. 집단 간 N250 성분에 차이를 보인 결과는 제2외국어로 한국어를 사용하는 이중언어 사용자는 한국어를 모국어로 습득한 경우보다 쓰여진 글자를 보고 처리하는 초기 과정에서 자소-음소 전환의 어려움을 보인다고 할 수 있다. 종합해보면 이중언어 사용자 일지라도 한국어에 노출되는 시간을 늘리고, 음운규칙이 적용되는 단어를 많이 접한다면 한국어 원어민과 동일한 자소-음소 전환 처리를 할 수 있다는 가능성을 제시한다.

본 연구의 제한점 및 후속연구를 위한 제언은 다음과 같다. 첫째, 실험에 사용된 과제는 이중언어 사용자를 대상으로 하여 시각자극을 제시하는 시간이 길었으며, 청각자극이 제시된 뒤 자소-음소 전환을 순수하게 보여주는 파형이라고 판단하기에는 무리가 있다. 둘째, 한국어의 경우 음운규칙을 적용하지 않고도 읽을 수 있기에 피험자들의 정오판단을 분명하게 하기 위해 문장 내 단어를 포함시키거나 시각자극을 제시한 뒤 읽도록 하는 등 피험자의 판단 과정을 단순화시킬 필요가 있다. 셋째, 이중언어 사용자 집단을 선정할 때 한국어 능력을 초급 이상이라는 최소한의 제한을 두고 실험을 진행하였으나 상대적으로 일본어-한국어 이중언어 사용자 집단은 평균 26.7개월, 중국어-한국어 사용자 집단은 평균 14.9개월의 학습기간을 보여 학습기간에 따른 한국어 능력의 차이가 결과에 영향을 주었을 가능성을 배제하기 어렵다. 향후 연구에서는 집단의 선정 기준을 명확히 통제하여 진행할 필요가 있다.

본 연구는 한국어 특수성을 고려하여 시각자극과 청각자극을 통해 단어를 재인하여 음운규칙 적용 여부에 따라 한국어 원어민과 이중언어 사용자의 처리과정과 ERP 성분의 차이를 알아보고자 한 연구로서, 한국어를 외국어로 습득하는 다문화 가정의 부모, 한국어를 배우는 과정인 이중언어 아동들에게 한국어 음운지식을 형성하기 위해 습득 과정보다 장시간 한국어의 노출과 음운규칙 적용의 기회를 제공할 필요하다는 점을 시사한다.