인공와우이식 아동의 음성 정서 인식

Recognition of Voice Emotion in School Aged Children with Cochlear Implants

Article information

Abstract

배경 및 목적

인공와우는 선천성 심도청각장애 아동의 말과 언어 발달을 위해 효과적인 청각적 피드백을 제공하는 기기이나, 음도를 포함한 운율 관련 정보는 제한적으로 제공하는 것으로 알려져 있다. 따라서 본 연구는 운율 정보가 필요한 음성 정서 인식에서 인공와우이식 아동이 보이는 특성을 살펴보고자 한다.

방법

인공와우이식 아동(CI) 10명과 건청 아동(NH) 10명을 대상으로, 4가지 정서(기쁨, 슬픔, 공포, 화남)로 녹음된 6개의 중립적인 문장을 들려주고 해당 정서를 확인하게 하였다. CI 아동은 말지각 능력이 높고(95%), 언어발달이 또래 수준으로 일반 초등학교에 다니는 아동이었다. 음성 정서 인식의 집단과 정서 유형 간의 차이를 보고 오류를 정서 유형별로 분석하였다.

결과

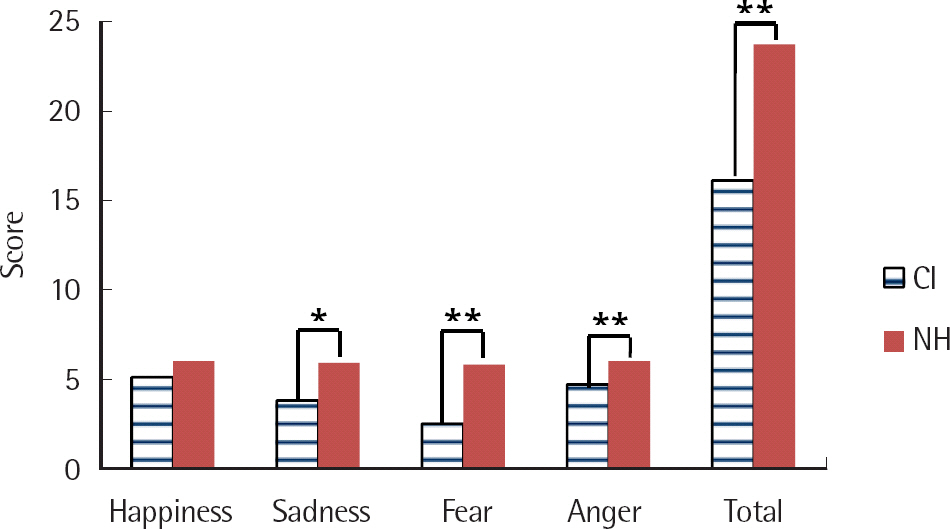

CI 집단의 음성 정서 인식 능력은 NH 집단보다 통계적으로 유의하게 낮았고(16.1 vs. 23.7), 유형 간에는 CI 집단에서 기쁨과 공포에 대한 인식 점수의 차이가 유의하였다(5.1 vs. 2.50). 오류 분석에서는 공포와 슬픔을 혼동하는 경우가 전체 오류의 47.36%를 차지했다.

논의 및 결론

말과 언어 발달에 문제가 없는 인공와우이식 아동의 경우에도 음성을 통한 정서 인식에는 어려움을 보였다. 이는 정서 인식에 필요한 운율 등의 초분절적 요소의 전달 제한과 정서 인식이 발달하는 생애 초기에 청각적 자극의 제한 때문으로 보이며 성공적인 학교생활과 대인관계 형성을 위해 이에 대한 중재가 필요함을 시사한다.

Trans Abstract

Objectives

The cochlear implant (CI) is a device providing congenitally deafened children with access to speech perception. Children with CIs may have good speech perception skills and language development, but still experience difficulties in the perception of prosody based on pitch information. The purpose of this study is to examine the difference between children with CIs and children with normal hearing (NH) in their voice emotion recognition abilities.

Methods

The participants were 10 children with CIs and 10 children with NH. Children with CIs all attended regular elementary schools, achieved a typical Developmental level on a formal language test, and demonstrated good speech perception abilities (95% in an open set word test). The accuracy of emotion recognition was evaluated by listening to a total of 24 sentences with four different emotions (happiness, sadness, fear, and anger).

Results

There were statistically significant differences between groups and also among emotions. Overall, children with CIs showed lower performance than children with NH in recognition of voice emotion (16.1 vs. 23.7). Children with CIs more accurately identified happiness than they did fear (5.1 vs. 2.5). Half of their total identification errors were between fear and sadness (47.36%).

Conclusion

The results indicate that children with CIs have difficulties in voice emotion recognition, even if they have no difficulties in speech perception or language development. In error analysis, difficulties in identifying between fear and sadness could be explained by confusion in same valence-arousal space. It is possible that prosodic elements of voice emotions were not sufficiently conveyed through the cochlear implant system. Such results highlight the need for a rehabilitation program addressing these features.

정서를 이해하는 능력은 사회적 발달에 있어서 매우 중요한 역할을 한다. 이러한 정서이해능력은 일반적으로 언어 자극에 충분히 노출되면서 일상적인 사회적 경험을 통해 자연스럽게 체득하게 되고, 정서를 파악하는 경험과 다양한 단서를 통해 정서를 표현하는 능력 또한 향상이 된다(Trainor, Austin, & Desjardins, 2000). 정서는 아동이 성장함에 따라 또래와의 관계를 잘 형성하는 데에 더욱 중요한 역할을 한다. 특히 성인의 개입 없이 아동이 스스로 부딪혀야 하는 상황이 많아지는 학령기에서 정서는 또래와 원활하게 의사소통하며 적절한 관계를 만들고 유지하기 위해 매우 중요한 요소라고 할 수 있다. 학령기 아동들은 내적인 정보와 상황적 정보를 모두 고려하여 정서를 파악할 수 있으며, 같은 상황에서 사람들마다 다른 정서를 나타낼 수 있다는 것을 이해한다(Ryu & Min, 2003).

정서를 이해하고 표현하는 단서는 언어적인 단서와 비언어적인 단서로 나뉜다. 언어적 단서는 문자로 기록될 수 있고 의미를 정확하게 전달할 수 있는 방법이며, 비언어적 단서는 언어로 전달되는 것 외의 표정, 제스처, 음도, 운율, 억양 등을 말한다(Planalp, 1996). 비언어적 단서에 속하는 음성은 청각적으로 받아들이는 자극으로 시각적인 표정만큼 정서를 전달하는 중요한 요소이다. 또한 의사소통 상황에서 언어적 단서와 관계없이 음성만으로 정서가 전달될 수 있으며 음성 정보 중 운율이 가장 큰 역할을 하는 것으로 알려져 있다(Planalp, 1996; Trainor et al., 2000). 일반적으로 영유아기 때부터 언어에서 중요한 단서를 운율적 특성에서 찾으며 운율을 이해하고 감지하는 능력을 습득한다(Trainor et al., 2000). 학령전기 아동의 경우 상황맥락과 내용에 기초하여 정서를 판단하는 경우가 많았으나, 학령기 이후는 상황 맥락과 운율을 함께 보거나 운율에 기초하여 판단하는 등 운율로 정서를 판단하는 비율이 높아지는 것으로 나타났다(Kang, Hwang, & Jeong, 2014; Park, 2010). 이러한 결과는 음성을 통한 정서 인식이 학령기 아동에게 중요함을 시사한다.

인공와우는 말소리를 듣지 못해서 언어발달이 어려운 선천성 청각장애 아동에게 청각적 피드백을 제공하는 기기이다. 선천성 청각장애 아동이라도 인공와우이식 후 청능 및 언어가 향상되며, 조기에 인공와우이식을 받고 적절한 중재를 받았을 때는 정상, 또는 정상에 가까운 말과 언어 발달이 가능한 것으로 알려졌다(Dillon, Cowan, & Ching, 2013; Nicholas & Geers, 2007; Yoon & Choi, 2010). 그러나 인공와우이식 후에도 운율과 음성 정서 인식에서는 어려움이 남는다는 연구결과들이 보고되고 있다(Choi & Lee, 2009; Hopyan, Gordon, & Papsin, 2011; Jiam, Caldwell, Deroche, Chatterjee, & Limb, 2017; Most & Aviner, 2009; Peng, Tomblin, & Turner, 2008; Volkova, Trehub, Schellenberg, Papsin, & Gorden, 2013; Waaramaa, Kukkonen, Mykkänen, & Geneid, 2018; Wang, Zhou, & Xu, 2011). 운율의 경우 인공와우 아동들은 의문문과 평서문을 구분하는 능력이 또래 건청 아동보다 낮고(Peng et al., 2008), 중국어와 같은 성조 언어에서 성조의 차이를 인식하기 어려워한다(Wang et al., 2011). 이는 운율 인식의 어려움을 넘어 구어 의사소통의 문제와 또래와의 상호작용에도 부정적인 영향을 준다. 인공와우이식 아동의 음성 정서 인식에 대한 연구는 의미적으로 중립적인 문장을 여러 가지 정서로 녹음하여 들려주고 어떤 정서였는가를 찾게 하는 방식으로 진행된다. 연구에 따라 제시하는 정서 유형의 수, 대상자의 연령, 대상자의 청력 수준 등에 따라 수행력의 차이가 있으나 건청 아동에 비해 정서 인식이 어렵다는 결과가 일반적이다. Choi 와 Lee (2009)에서 인공와우 아동들은 화남, 슬픔, 기쁨, 공포의 네 가지 정서 인식에 대해 건청 성인(88.49%)과 건청 아동(65.79%)에 비해 낮은 수행률(46.17%)을 보였다. 말소리 자극과 음악 자극에서 기쁨과 슬픔의 두 가지 정서 유형을 비교하였을 때 인공와우 아동의 인식 능력은 건청 아동에 비해서는 유의하게 낮은 수준이었다(Volkova et al., 2013). Most와 Aviner (2009)는 인공와우이식을 6세 이전에 받은 집단, 6세 이후에 받은 집단, 보청기 사용 집단, 건청 아동 집단을 대상으로 청각, 시각, 시청각 자극에 따른 정서 인식을 살펴보았다. 건청 아동 집단은 청각자극에 대해 청각장애 아동 집단보다 수행력이 유의하게 높았고, 시청각 자극에 대한 반응이 청각 자극만 주었을 때보다 높았다. 그러나 청각장애 아동은 자극의 차이에 대해 수행력의 차이를 보이지 않았으며, 집단 간 차이도 유의하지 않았다. 인공와우이식 시기와 관련하여 이식 나이를 3세 기준으로 나누었을 때는, 인공와우이식의 나이가 정서 인식에 영향을 주어 일찍 이식을 받은 아동들의 수행력이 높았다(Waaramaa et al., 2018).

인공와우 아동이 정서 인식에 어려움을 보이는 원인은 다양한 요인으로 추정해 볼 수 있다. 먼저 인공와우 시스템의 문제이다. 인공와우 시스템은 스펙트럼-시간적 미세 구조(spectro-temporal fine structure) 정보 전달에 한계가 있어 제한된 음도와 운율 정보를 전달하므로, 이는 운율과 정서 인식의 어려움으로 이어질 수 있다(Kong, Mullangi, Marozeau, & Epstein, 2011). 정상 청력을 가진 사람에게 인공와우의 말합성기와 유사한 조건(8-channel noise-vocoded speech)으로 합성한 말자극을 들려주었을 때, 정상 청력의 성인도 인공와우 이식자와 유사한 수준의 음성 정서 인식 능력을 보인 것은 이러한 가능성을 보여준다(Chatterjee et al., 2015). 또 다른 가능성은 정서 인식의 발달과 관련한 문제이다. 일반적인 발달 과정에서 보면 정서 인식과 표현은 영유아기부터 이루어지며 외부 자극을 필요로 한다(Trainor et al., 2000). 현재 선천성 청각장애 아동의 인공와우이식은 일반적으로 생후 12개월 이후 진행되고 있으며 그 전에는 보청기를 사용하고 있으나 심도 난청 아동은 보청기를 통해 말소리를 듣기가 어렵다. 따라서 정서 인식의 발달에 필요한 음성 자극을 듣지 못하며 이로 인해 초기 정서 인식의 발달에 제한이 있을 가능성이 있다(Pisoni, Conway, Kronenberger, Henning, & Anaya, 2010).

인공와우이식 이후 청능과 언어 발달이 원활하게 이루어져 일반학교에 재학 중인 청각장애 아동의 경우, 음성 정서 인식에 어려움을 보인다면 효과적으로 의사소통을 하고 또래와 사회적 관계를 형성하는 것에 어려움이 있을 수 있다. 또한 정서 인식 능력은 인공와우 아동의 삶의 만족도에도 영향을 주는 것으로 알려져 있다. 5-14세 학령기의 인공와우이식 아동 37명을 대상으로 한 연구에서, 정서 확인 과제의 수행력은 아동들이 직접 답한 삶의 질의 높은 수준을 예측하는 유의한 변인이었다(Schorr, Roth, & Fox, 2009). 따라서 성공적인 학령기를 위해 인공와우이식 아동의 정서 인식 능력을 분석하고 필요하다면 도움을 줄 수 있는 방법을 찾아야 할 것이다.

본 연구는 학령기 인공와우이식 아동 집단과 건청 아동 집단에서 음성 정서 인식 능력의 차이와 오류를 분석하여 음성 정서 인식 능력 향상을 위한 중재의 근거를 마련하고자 한다. 연구 질문은 첫째, 정서 인식 능력에서 집단 간 차이가 있는가, 둘째, 집단 내에서 정서 유형 간 차이가 있는가, 셋째, 오류 유형은 어떤 특징을 보이는 가이다. 연구대상은 말소리 지각과 언어 발달 수준이 일반 또래 아동의 범주에 있는 인공와우이식 아동으로 한정하였다. 다양한 정서 유형 중에서는 학령기 아동이 확실히 반응하며, 인공와우이식 아동의 선행연구에서 주로 사용되었던 정서 유형인 기쁨, 슬픔, 공포, 화남의 네 가지 정서 유형에 대해 살펴보았다(Chatterjee et al., 2015; Choi & Lee, 2009; Jiam et al., 2017; Lee, 2015).

연구방법

연구대상

본 연구는 일반 초등학교에 재학 중인 인공와우이식 아동 10명과, 이들과 성별 및 생활연령을 일치시킨 건청 아동 10명의 총 20명의 아동을 대상으로 하였다.

인공와우이식 아동은 (1) 선천성 청각장애로, (2) 구어를 주요의사소통 수단으로 사용하며, (3) 청각장애 이외에 중복장애가 없고, (4) 수용 ·표현어휘력검사(Receptive & Expressive Vocabulary Test, REVT; Kim, Hong, Kim, Jang, & Lee, 2009) 결과 언어연령이 생활연령 범주에 속하며, (5) 어음청력검사(Korean Speech Audiometry, KSA; Lee et al., 2010)의 학령기용 단어인지검사에서 70% 이상의 말지각 능력을 보이는 아동을 대상으로 선정하였다. 건청 아동은 인공와우이식 아동과 생활연령을 일대일로 대응시켰으며, (1) 부모 보고에 의해 확인된 장애가 없고, (2) 수용·표현어휘력검사(REVT) 결과 언어연령이 생활연령 범주에 속하며, (3) 어음청력검사(KSA)에서 100% 수행 가능한 아동을 대상으로 선정하였다. 선정된 인공와우이식 아동에서 양이이식 아동이 5명, 일측이식 아동이 5명이었고, 이들의 생활연령, 언어검사 점수, 말지각검사 점수, 조음검사 점수는 건청 아동과 유의한 차이가 없었다 (p>.01). 대상 아동의 정보는 Table 1과 같다.

검사도구

본 연구에서는 음성 정서 인식 능력을 평가하기 위하여 음성 정서 인식 검사 문항을 개발하여 사용하였다. 검사 문항은 고빈도 어휘 단어를 사용하여 의미적으로 정서가 포함되지 않는 중립적인 문장으로 만들었다. 각 문장은 음절수를 7-8음절로, 어절수를 2-3어절로 일치시켜 일차적으로 10개의 문장을 만들었다. 연구자가 제작한 10개의 문장에 대해 언어치료전공 박사학위소지자 1명과 언어치료 3년 이상 경력의 치료사 5명에게 내용타당도에 관한 평가를 받았다. 내용타당도에서는 정서에 영향을 줄 수 있는 요소나 어휘의 친숙도를 평가하도록 하였고, 낮게 평가된 4문장을 제외한 6개 문장을 최종 선택하였다. 최종 선정된 6개 문장은 Appendix 1에 수록하였다.

표준말을 사용하는 성인 여성에게 선정된 6개 문장을 각각 네 가지 정서(기쁨, 슬픔, 화남, 공포)로 3회씩 표현하게 하여 총 72개의 녹음 파일을 만들었다. 녹음은 방음부스에서 외부마이크(Shure-SM58SK)를 연결한 녹음기(Edirol R-09HR)로 진행하였다. 제1연구자와 언어재활사 1명이 각 문장별로 특정 정서에 대해 녹음한 세 개의 파일을 듣고, 0 (부적절)-1 (적절)-2 (매우 적절)로 점수를 주어 가장 높은 점수를 보인 녹음 파일을 해당 문장의 정서 유형으로 선택했다. 이렇게 선택된 24개의 녹음 파일(6개 문장×4개 정서)을 문장과 정서유형을 무선으로 배치하여 음성 정서 인식 검사 문항을 완성했다. 최종 완성된 음성 정서 인식 평가 검사를 대학생 청자 14명에게 들려주고 문항별로 검사지에 표시된 네 가지 정서 유형 중 선택하도록 한 결과, 평가자 전원이 각 문항에서 의도된 정서를 100% 정확하게 확인하였다.

연구절차

사전 검사

주 양육자와의 면담을 통해 인공와우와 관련된 아동의 배경정보를 수집하고 사전 검사로 말지각 능력, 어휘력, 조음 능력을 주변 소음이 없는 조용한 방에서 평가하였다. 대상자의 말지각 능력은 어음청력검사(KSA)의 학령기용 단어인지검사를 auditory only (AO)상황에서 직접 들려주고 평가하였다. 어휘력은 수용 ·표현어휘력검사(REVT)의 표현어휘력 검사로, 조음 능력은 우리말 조음음운평가(Urimal Test of Articulation And Phonology, U-TAP; Kim & Shin, 2004)의 자음정확도로 측정하였다.

음성 정서 인식 능력

연구자는 검사를 시작하기 전 먼저 대상자에게 네 개의 정서 유형(기쁨, 슬픔, 화남, 공포)의 의미를 아는지 묻고, 예를 들어보도록 요청했다. 대상자 전원은 네 가지 정서 유형의 의미를 이해하고 있었고, ‘공포’의 경우에도 한자어이기에 우려가 되었으나 대상자들은 ‘공포’의 의미를 무서움이나 두려움이라고 정확히 표현했다. 인공와우이식 아동은 언어치료센터 안의 조용하고 독립된 방에서, 건청 아동은 아동의 집이나 교회 주일 학교의 조용한 방에서 실험을 진행했다. 가능한 한 외부 소음이 차단된 상황에서 검사자와 아동이 일대일로 책상에 마주 앉았고, 노트북에 연결된 스피커(Britz-e BE-100 Soundbar)를 책상 위 대상자의 정면 약 30 cm 거리에 두고 음성 정서 인식 검사 문항의 녹음 파일을 들려주었다. 소리 크기는 연습 문항을 들려주며 대상자가 잘 들린다고 하는 수준으로 조정하였다. 연구자는 “지금부터 ○○이에게 한 문장씩 들려줄 거예요. ○○이는 문장을 듣고 말하는 사람의 기분이 어떤 것 같은지 답지에 체크해 주면 돼요. 기분에는 기쁨, 슬픔, 화남, 공포가 있어요.”라고 안내하였다.

자료 분석

검사가 끝난 후 답지를 수거하여 아동의 반응이 의도된 정서와 일치할 때 1점, 다를 때 0점으로 채점하여, 각 정서 유형당 6점, 총 24점을 만점으로 음성 정서 인식 능력 점수를 산출하였다. 아동의 오류를 분석하기 위해 네 개 유형으로 매트릭스를 만들고 전체 오류수를 분모로, 각 셀에 나타난 오류수를 분자로 하여 오류율을 산출했다. 음성 정서 인식에 대해 집단 간(인공와우이식 아동 vs. 건청 아동)과 집단 내(기쁨 vs. 슬픔 vs. 공포 vs. 화남)의 혼합설계로 분석하고 사후검정을 하였으며 오류분석을 하였다. 자료의 통계적 처리는 SPSS version 18을 사용하였다.

연구결과

음성 정서 인식 능력의 차이

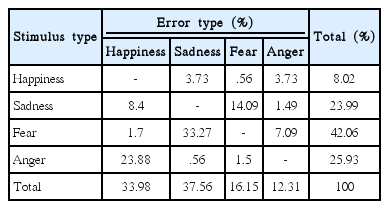

음성 정서 인식에 대한 집단과 유형의 이원분산분석 결과 집단과 유형 간 모두 유의한 차이가 있었고 (F(1, 72) = 39.5, p< .001; F(3, 72) = 4.26, p < .001), 두 변인 간의 상호작용도 유의한 것으로 나타났다 (F(3, 72) = 3.06, p < .05) (Table 2). 사후 분석 결과 인공와우이식 아동 집단은 건청 아동보다 모든 정서 유형에 대해 낮은 점수를 보였으며, 기쁨을 제외한 슬픔, 공포, 화남의 세 가지 정서 유형에 대한 차이는 통계적으로 유의하였다 (p < .01) (Figure 1). 집단 내의 정서 유형별 차이는 인공와우 집단에서 기쁨과 공포에 대한 차이만이 유 의하였다 (p < .05) (Figure 2). Sadness 8.4 – 14.09 1. Fear 1.7 33.27 – 7. Anger 23.88 0.56 1.5 -Total 33.98 37.56 16.15 12.

Group comparison of voice emotion recognition.

CI=children with cochlear implants; NH=children with normal hearing.

*p<.05, **p<.01.

오류 분석

인공와우이식 아동의 음성 정서 인식 과제의 오류 유형을 살펴본 결과, Table 3과 같으며, 공포(42.06%), 화남(25.93%), 슬픔(23.99%), 기쁨(8.02%) 순으로 정서 인식오류를 많이 보였다. 오류를 분석한 결과, 공포를 슬픔으로 인식한 경우가 33.27%로 가장 많이 나타났으며, 그 다음은 화남을 기쁨으로 인식한 경우(23.88%), 슬픔을 공포로 인식한 경우(14.09%)로 나타났다. 공포-슬픔의 오류는 전체 오류 중 47.36%를 차지했다.

논의 및 결론

본 연구는 초등학교 1-5학년 인공와우이식 아동 집단과 건청 아동 집단에서 음성 정서 인식 능력에 대한 집단 간, 정서 유형 간 차이와 오류 분석을 통해 인공와우이식 아동의 음성 정서 인식 능력 향상을 위한 중재의 근거를 마련하는 것을 목적으로 하였다. 연구 결과, 음성 정서 인식 능력은 모든 정서 유형에서 인공와우이식 아동 집단이 건청 아동 집단보다 더 낮은 수행력을 보였으며, 이러한 차이는 기쁨을 제외한 세 가지 정서 유형에서 통계적으로 유의하였다. 두 집단은 생활연령, 공식 검사의 언어연령, 조음 능력 및 듣기 능력에 차이가 없었다. 인공와우이식 아동 집단은 말지각 능력이 평균 95.2%이며, 그중 7명의 아동은 말지각 능력이 100%를 보인 아동이었으나, 음성 정서 인식 능력은 또래 건청 아동과 차이를 보였다. 이는 인공와우를 통해 말소리를 듣고 어떤 말인지 인지하는 데에 어려움이 없는 경우에도 말소리에 담긴 정서를 인식하는 것에 어려움이 남아있음을 의미한다.

인공와우이식 아동이 말소리의 운율을 포함하여 정서를 인식하는 데에 어려움을 보이는 원인은 몇 가지로 추정할 수 있다. 먼저 인공와우 시스템이 갖고 있는 한계와 관련된 것이다. 즉 인공와우 시스템은 음도를 포함한 음향적 요소의 전달에 한계가 있으며, 이는 운율과 정서 전달의 어려움으로 이어지기 때문이다(Kong et al., 2011). 또 하나의 요인으로 추정해 볼 수 있는 것은 정서 인식의 발달 시기와 관련된 요인이다. 최근 청각장애 아동의 듣기와 언어 발달이 생애 첫 수년 동안 제한되었을 때 일어나는 뇌의 발달과 관련된 연구들이 활발히 진행되었다. 그 과정에서 알게 된 것은 인공와우이식을 통해 아동의 현재 듣기와 언어능력이 또래와 같은 수준에 있다 하여도 그것이 다른 인지 영역도 건청 아동과 같은 수준이라는 것을 보장하지는 않는다는 사실이다. 아동의 인지 영역의 어려움은 현재가 아니라 생애 초기에 받은 자극에 의해 영향을 받는 것으로 추정된다. 즉 생애 첫 1년을 포함한 생애 초기에 정서 유형을 받아들이고 표현하는 정서 지각의 발달이 외부 자극을 통해 이루어지는데, 선천성 심도청각장애 아동의 경우에는 이 시기에 청각적인 자극이 차단되어 건청 또래와 같은 발달이 이루어지기 어려울 것으로 추정되고 있다(Pisoni et al., 2010). 따라서 본 연구에 참여한 아동들과 같이 현재 건청 또래와 같은 수준의 듣기와 언어발달을 보이는 아동이라 하여도 이들은 생애 초기에 청각적 자극을 받지 못했고 이러한 자극의 결핍이 정서 인식의 발달에 영향을 주어 본 연구 결과와 같이 음성 정서 인식에 어려움을 주었을 것으로 추정해 볼 수 있다. 나아가서 Lee (2015)는 마음읽기 능력과 음성 정서 인식 능력은 높은 상관관계를 보이는 것으로 보고하고 음성 정서 인식 능력의 어려움에는 청각적인 요소뿐만 아니라 마음읽기 능력의 결함도 영향을 주는 것으로 추정하였다. 본 연구의 대상자는 선천성 청각장애 아동으로, 이들의 낮은 음성 정서 인식에는 이와 같은 요인이 관여했을 가능성을 배제할 수 없으나 본 연구에서 직접 확인할 수는 없었다.

각 집단 내에서 정서 유형에 따른 음성 정서 인식 수행력에 유의한 차이가 있는지 살펴본 결과, 인공와우이식 집단에서만 유의한 차이를 보였다. 인공와우이식 아동은 정서 유형 중 기쁨을 가장 잘 인식하였고, 공포를 가장 어려워하였다. Lee (2015)는 평균 11.2세의 인공와우이식 아동을 대상으로 정서 인식을 보았고, 이들도 네 가지 정서 중 기쁨에서 가장 높은 수행력을, 공포에서 가장 낮은 수행력을 보였다. 음악을 통해 기쁨과 슬픔의 두 가지 정서를 비교했을 때 인공와우이식 아동들은 기쁨을 더 정확히 인식했다(Hopyan et al., 2011). 반면 Waaramaa 등(2018)은 신남(excitement), 화남(anger), 만족(contentment), 공포(fear)의 네 가지 정서에 대한 인식을 보았는데, 인공와우 아동들은 화남을 가장 잘 인식하였고 공포를 가장 어려워하였다. 인공와우 사용자가 음성 정서 유형 중 공포의 인식을 어려워하는 것은 Paquette, Takerkart, Saget, Peretz와 Belin (2018)의 연구에서도 확인되었다.

정서 연구에서 유형 분류는 다양한 차원이 존재하나 음성언어 연구에서는 이차원의 긍부정-각성 모델(valence-arousal model)이 주로 사용된다. 긍부정-각성 모델에서 긍부정(valence)은 가로축으로 긍정(positive)에서 부정(negative)까지, 각성(arousal)은 세로축으로 고(high)에서 저(low)까지로 나타내며, 이 두 개의 축으로 분할되는 네 개의 공간에 정서 유형이 배치된다(Scherer, 1986). 기쁨과 화남은 긍부정은 다르나 고-각성이라는 공통점을 갖는다. 즉 인공와우 아동들이 고-각성의 정서인식을 보다 쉬워한다는 유추가 가능하며, 이는 기쁨(고-각성)과 슬픔(저-각성)의 두 가지 정서를 대상으로 한 연구에서 기쁨에 대한 정확도가 높은 것으로도 연결이 된다. 일반적으로 기쁨이 음도가 높고 음도 변화의 폭이 큰 점도 기쁨의 인식을 보다 쉽게 하는 데에 영향을 주는 것으로 보고되었다(Chatterjee et al., 2015).

음성 정서 인식에서 나타난 오류를 분석한 결과 전체 오류 중 공포를 슬픔으로 인식하는 경우가 가장 많았고, 화남을 기쁨으로 인식하는 경우, 슬픔을 공포로 인식하는 경우가 상위를 차지했다. 이중 공포와 슬픔의 정서를 혼동하는 경우는 전체 오류의 거의 절반을 차지했다(47.36%). 공포와 슬픔은 긍부정에서 부정의 공간에, 각성에서는 저-각성의 공간에 있다. 따라서 인공와우이식 아동이 공포와 슬픔을 혼동하는 경향이 높은 것은 이들 두 가지 정서가 같은 공간에 있었기 때문으로 유추된다. Waarama 등(2018)의 연구에서는 공포와 만족의 혼동이 두드러졌는데, 이 두 가지 정서는 긍부정 차원에서는 다르나 동일하게 저-각성의 공간에 위치한다. 음향학적 변인과 각성의 관계를 보면 고-각성은 높은 음도, 저-각성은 낮은 음도와 연관이 있는 것으로 알려져 있다(Jiam et al., 2017; Waarama et al., 2018). 이러한 결과는 인공와우이식 아동이 보여준 정서 인식 오류의 원인 중 하나로 음도 정보를 충분히 전달하지 못하는 인공와우 시스템의 제한 때문이라는 가능성을 지지한다(Chatterjee et al., 2015; Kong et al., 2011).

본 연구에서는 듣기 능력이 우수한 인공와우이식 아동들을 대상으로 하였음에도 또래 건청 아동의 음성 정서 인식 능력과 차이가 있었다. 이는 또래와의 상호작용 시 비언어적 정보처리에 어려움이 있을 수 있으며, 또래로부터 따돌림이나 대인관계의 문제로도 발전될 수 있는 사항이다. 대인관계에서 문제가 생길 시 정서를 정확하게 파악하고 적절하게 표현하는 사람일수록 긍정적으로 해결할 수 있으며, 대인관계를 만들고 유지하는 것에도 긍정적인 결과를 나타내는 것으로 나타난다(Lee & Lee, 2013). 또한, 정서 인식을 잘하는 인공와우이식 아동의 경우 삶의 질이 높다는 연구 결과(Schorr et al., 2009)에 따라서도 인공와우이식 아동의 정서 인식 능력은 중요한 부분이며, 향후 음성 정서 인식 향상에 초점을 둔 중재의 필요성을 시사한다. 중재의 필요성과 더불어 생각할 것은 인공와우 아동의 정서 인식 능력이 인공와우이식 나이에 따라 유의하게 차이가 난다는 연구 결과이다. Waaramaa 등(2018)은 인공와우이식 아동의 정서 인식 능력이 생활연령과는 상관이 없으나 인공와우이식 연령과는 유의한 상관이 있고 36개월 이전에 수술받은 아동의 수행력이 36개월 이후에 수술받은 아동보다 유의하게 높다고 보고하였다. 따라서 Mildner와 Koska (2014)의 제안과 같이 조기진단과 조기중재로 어린 나이에 인공와우이식을 받고 지속적인 청각과 구어 중심의 중재를 통해 정서 인식과 표현 능력을 높이는 중재가 필요할 것이다.

본 연구는 청각적인 통로인 음성 정서 인식만을 살펴보았다. 그러나 시각과 청각 단서가 모두 제공된 상태에서의 정서 인식 양상을 살펴본다면 인공와우 이식 아동이 보이는 음성인식의 어려움에 대한 보다 포괄적인 확인이 가능할 것이므로 이에 대한 후속 연구를 제안한다.